(1)

Deepmind 的 DQN 在 Atari 的七个不同的游戏 (Beam Rider, Breakout, Enduro, Pong, Q*bert, Seaquest, Space Invaders) 中,有六个游戏的最高得分都超过了人类的最好玩家.

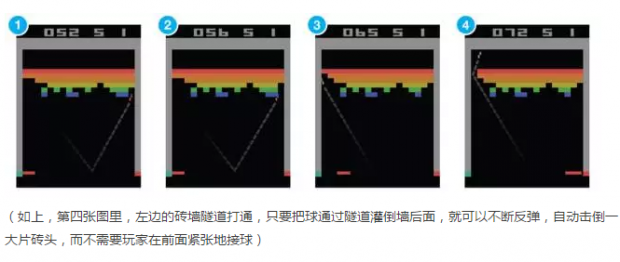

最出乎人们意料的是程序在 Breakout (突围)游戏中的表现.

刚开始, 不了解游戏规则的程序,表现得像个无头苍蝇,老是漏球.

经过10分钟的训练后,慢慢懂得要用板子击球,才可以得分.

经过120分钟的训练后,程序可以迅速准确击球,表现得有点专家的味道了.

经过240分钟的训练后,程序发现了一个获得高分的捷径:

不断用板子击球到最左边,连续数次后左边的几层砖头全部击倒打通,随后击球就可以经过这个隧道绕到墙的后面,在墙壁后面多次连续反弹击倒一大片砖头,获得高分.

这个精巧的打法,是程序设计者事前完完全全没有想到的.

(2)

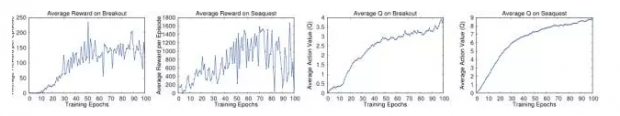

在训练过程中还有这样一个问题,由于算法在决策过程中总是有一定几率的随机探索,每局游戏的比分总是有些随机的波动。对于一个普通观察者来说,在一个较短的时间段内,他只看到每局得分大起大落,但无法准确判断程序是否真正学到了东西,有技能的提高.

这里对于价值函数最大值 Q-value 的估算就派上用场了, 如下图. 左边两图是程序在多次培训后平均得分的曲线图。对于旁观者而言,图中的右半部波动较大,看不出得分有什么进步。 右边两图,则是神经网络对 Q-value 的估值,这个数字,则是一直缓缓上升的。

这里面有个非常深刻的洞见:如果人们总是让人生旅程上短期的得失,尤其是因为偶然不可控因素导致的得失,影响情绪上的波动,那么精神状态就会象左边两张图一样忽上忽下,而随之而来的狂躁症,忧郁症,双向情感障碍,也就成为必然.

但如果树立了科学的方法论和价值观,可以正确地估算 Q-value, 面对短期的大起大落,知道自己实际上是在不断进步,知道未来在变得更好,知道短期的挫折或者成就以后不值一提,所以可以拒绝一惊一乍,所以可以坚持平心静气.

所谓宠辱不惊,原来无非如此.

(3)

回头看,如果要总结为什么机器打游戏彻底超越人类玩家,主要原因还是三点:

第一,计算能力的大幅度提升,这是最根本的.

和在西洋双陆棋上实现突破的 1992年时相比,2013年的使用 GPU的计算能力至少增加了几十万倍。只有这样的计算能力,才能够处理复杂的神经网络模型和海量的输入数据.

第二, 算法的改进

这里,主要是深度神经网络,经历回放和传统增强学习的理论模型的结合。

第三,由于计算速度的提高,和算法的改进,机器有能力探索更广阔的状态空间,从而有能力发现人类从未感知的一个全新的世界.

更重要的是,和图像识别,语音识别这类有明确标准答案的问题不同,这一次,程序设计者甚至都没有设定任何明确的游戏规则,只有游戏屏幕的原始像素的输入,和游戏得分的回馈,其它一切让机器自己去摸索.

然后机器发现了比人类更好的打法.

这让学者们看到了实现真正的 “强人工智能”, (机器自发解决以前只有人类才可解决的抽象问题)的希望.

机器超越人的智能,本质上也无非就是 算得更快,记得更多,更善于探索 而已。

2014年一月,谷歌宣布以五亿美元收购 Deepmind. 对于大多数吃瓜群众而言,一个没有什么收入,就是写了个可以打游戏的程序的公司, 估值五亿,完全不可思议.

吃瓜群众焉知人工智能之志哉?

有诗为证: “飞来山上千寻塔,闻说鸡鸣见日升,不畏浮云遮望眼,自缘身在最高层".

(未完待续)

0

推荐

京公网安备 11010502034662号

京公网安备 11010502034662号